# 생성형 AI와 인간의 협업 모델: 교육, 디자인, 저널리즘 분야를 중심으로 한 성과 분석 기반 선행연구

## 1. 서론

### 1.1 연구의 배경 및 의의

생성형 AI(Generative AI)의 급속한 발전은 인간의 창의적 작업 과정에 구조적 변화를 초래하고 있다. ChatGPT, DALL-E, Midjourney 등 대규모 언어 모델(Large Language Models, LLMs)과 이미지 생성 모델이 대중화되면서, 과거 인간의 고유한 영역으로 여겨지던 창의성, 문제 해결, 의사결정 등의 영역까지 AI가 진입하게 되었다. 특히 교육, 디자인, 저널리즘 분야에서는 AI와 인간이 상호 보완적으로 협업하는 새로운 패러다임이 형성되고 있다.

다만, AI와 인간의 협업이 실제로 어떻게 구성되고, 어떤 메커니즘으로 작동하며, 이것이 창의성, 생산성, 효율성 등의 성과에 어떤 영향을 주는지에 대한 체계적 이해는 여전히 부족한 상황이다. 따라서 본 선행연구는 2018년부터 2025년까지의 주요 학술 논문, 산업 리포트, 사례 연구를 종합하여 AI-인간 협업의 구조, 유형, 성과 및 한계를 분석하고자 한다.

### 1.2 연구 문제

이 선행연구는 다음의 핵심 질문들을 다룬다:

1. 생성형 AI와 인간 간의 협업 모델은 어떻게 분류 및 정의할 수 있는가?

2. 교육, 디자인, 저널리즘 분야에서 구체적으로 어떤 협업 구조가 나타나고 있는가?

3. 협업 모델이 창의성, 생산성, 효율성 등의 성과에 미친 영향은 무엇인가?

4. 각 분야 간 협업 방식의 공통점과 차이점은 무엇인가?

5. 현재 협업 모델의 한계와 향후 발전 방향은 무엇인가?

---

## 2. 생성형 AI와 인간의 협업 모델: 분류체계

### 2.1 협업 모델의 기본 유형

선행연구에서 나타나는 AI와 인간의 협업 모델은 AI가 맡는 역할에 따라 크게 다음과 같이 분류된다:

#### 2.1.1 보조자(Assistant) 모델

AI가 인간의 작업을 보조하는 역할을 수행하는 모델이다. 이 경우 인간이 주도권을 유지하며, AI는 자동 완성, 오류 검출, 데이터 검색, 초안 작성 등의 지원 업무를 담당한다.

**특징:**

- 인간의 의사결정권이 최전선에 위치

- AI의 역할이 명확하게 정의됨

- 전통적 업무 구조의 자동화 수준이 높음

- 인간이 AI 출력에 대한 최종 검수 권한 보유

**사례:**

- 저널리즘: AI가 초안을 생성하면 기자가 검토·수정·보완

- 교육: 자동 채점 및 피드백 생성 후 교사가 검토

- 디자인: 배경 제거, 색상 조정 등 기술적 보조

#### 2.1.2 공동 창작자(Co-creator) 모델

AI와 인간이 창의적 과정에 동등하게 참여하는 모델이다. 이 경우 양측이 아이디어 생성, 개선, 평가에 함께 참여하며, 반복적 피드백 루프를 통해 결과물을 발전시킨다.

**특징:**

- 쌍방향 상호작용(interactive collaboration)

- 인간의 창의성과 AI의 생성능력이 상호 보완

- 반복적 개선 과정에서 자신감 및 자기 효능감 증대

- 최종 산출물이 양측의 기여의 혼합물

**사례:**

- 디자인: Midjourney를 활용한 협업적 이미지 생성 및 개선

- 창작 글쓰기: ChatGPT와의 상호작용을 통한 텍스트 개발

- 아이디어 브레인스토밍: AI가 제안한 개념을 인간이 확장하고 정제

#### 2.1.3 제안자(Suggester) 모델

AI가 여러 옵션, 아이디어, 관점을 제시하고, 인간이 그 중에서 선택하고 방향을 결정하는 모델이다. AI는 가능성의 공간(possibility space)을 확장시키는 역할을 수행한다.

**특징:**

- AI는 다양한 대안 제시

- 인간이 비판적 판단을 통해 선택

- 인간의 창의적 판단력이 핵심

- 새로운 관점 발굴에 유용

**사례:**

- 광고/마케팅: AI가 여러 헤드라인 옵션 제시, 마케터가 선택

- 교육: 다양한 학습 경로 제안 후 학생이 선택

- 저널리즘: 여러 기사 구성 방안 제시 후 에디터가 결정

### 2.2 협업 모델의 역할 분담 차원

협업의 질을 결정하는 중요한 요소는 인간이 어떤 역할을 부여받는가이다. 최근 연구에 따르면, 인간에게 **편집자(Editor)** 역할을 주는 것보다 **공동 창작자(Co-creator)** 역할을 주는 것이 훨씬 더 효과적이다.

**역할에 따른 성과 차이:**

AI가 초안을 생성하고 인간이 이를 개선하는 편집자 모델에서는:

- 인간의 창의적 자기 효능감(creative self-efficacy)이 낮아짐

- 고착 효과(anchoring effect)로 인해 충분한 수정이 이루어지지 않음

- 창의성 결손이 발생함

반면, 공동 창작자 모델에서는:

- 인간의 창의적 자기 효능감이 유의미하게 높아짐

- 내재적 동기(intrinsic motivation)가 증대됨

- 창의성 결손이 해소되고 더욱 혁신적인 결과물 생성

---

## 3. 분야별 협업 구조 및 사례 분석

### 3.1 교육 분야

#### 3.1.1 협업 모델의 유형

교육 분야에서 나타나는 AI와 인간(교사/학생)의 협업은 주로 다음과 같은 형태를 보인다:

**① AI 튜터링 시스템(AI Tutoring Systems)**

지능형 교수 시스템(Intelligent Tutoring Systems, ITS)은 AI가 학생의 개별 학습 수준에 맞춰 맞춤형 피드백과 설명을 제공하는 협업 모델이다.

**구조:**

- 학생 → AI 튜터: 질문/학습 요청

- AI 튜터 → 학생: 맞춤형 설명, 피드백, 새로운 문제 제시

- 교사 → 감독 및 개입: 필요시 직접 개입

**실제 성과:**

- 학습 성과 향상: 실험군이 대조군 대비 15~35% 성과 증가

- 구체적 사례: Yixue 사용자가 비사용 그룹 대비 4.62배 높은 학습 이득 달성

- 지식 보유율: IT 전문가 대상 AI 적응형 훈련에서 35% 향상

- 시간 절감: 훈련 시간 22% 단축

- 학생 참여도: 20~35% 증가

**②교사 피드백 자동 생성 시스템**

AI가 학생의 과제나 시험을 평가하고 개선 방안을 제시함으로써, 교사의 채점 업무를 보조하고 더 나은 피드백을 제공하도록 지원한다.

**구조:**

- 학생 → 과제 제출

- AI → 자동 채점 및 피드백 생성

- 교사 → AI 피드백 검토·보완 후 학생에게 전달

**실제 성과:**

- 교사 업무 시간: 80% 단축

- 채점 속도 대폭 향상

- 피드백 일관성: 인간의 주관적 편차 감소

- 정확도: 높은 신뢰도 유지 (적절한 프롬프팅 시)

**③교사 수업 분석 및 개선 지원**

AI가 교사의 수업을 분석하여 교수법 개선을 위한 피드백을 제공한다.

**사례와 성과:**

- 2023 연구: 교사 대시보드를 활용한 학생 아이디어 흡수(uptake) 향상

- AI 피드백을 받은 교사가 그렇지 않은 교사 대비 학생 아이디어 흡수 13% 증가

- 자동 음성 인식을 통한 수업 분석: 250명 이상의 교사가 참여한 연구에서 자동 피드백의 잠재성 확인

**④AI 시뮬레이션 학생을 통한 교사 훈련**

예비 교사들이 AI 시뮬레이션 학생과의 상호작용을 통해 피드백 제공, 질문 방식, 설명 등을 연습한다.

**성과:**

- 반복 가능한 학습 환경 제공

- 교사가 여러 교수 전략을 안전하게 시도 가능

- 심화된 내용 이해 및 즉시적 문제 해결

- 아이디어 정제 및 포용적 언어 개발

#### 3.1.2 교육 분야의 협업 메커니즘

**인간-AI 협업 학습 프레임워크(Inclusive Collaborative Learning Framework):**

최근 연구는 STEM 교사 교육에서 세 가지 협업 접근을 비교했다:

1. **교사-학생 쌍 학습(TSPL)**: 전통적 인간 협력

2. **ChatGPT-학생 쌍 학습(CSPL)**: AI와의 협력

3. **통합 하이브리드 모델(iHMCL)**: 인간과 AI 피드백의 혼합

**결과:**

- CSPL과 iHMCL: STEM 교수 지식 및 인지 부하 관리에서 우수

- TSPL과 iHMCL: 교수 능력에서 우수

- 하이브리드 모델이 가장 효과적

**자결성 이론(Self-Determination Theory) 적용:**

- 자율성(autonomy): 학생이 학습 경로 선택 시 증대

- 유능감(competence): 타겟된 AI 피드백으로 향상

- 관계성(relatedness): 교사의 정서적 지원과 결합 시 강화

### 3.2 디자인/창의 분야

#### 3.2.1 협업 구조

디자인 분야에서 AI와 인간의 협업은 주로 **아이디어 생성 단계**에서 시작하여 **개념 개발, 시각화, 프로토타이핑**으로 진행된다.

**모델: 인간-AI 협력적 창의 디자인 프로세스(HAI-CDP)**

**단계별 협업 구조:**

**1단계: 문제 정의 및 아이디어 생성**

- 인간: 문제 정의, 디자인 요구사항 설정

- AI: 관련 사례, 트렌드, 다양한 아이디어 옵션 제시

- 협력 방식: 보조자 모델 + 제안자 모델

**2단계: 개념 개발**

- 인간: 아이디어 평가, 방향 설정, 개선점 지시

- AI: 시각 자료 생성, 개념 발전, 대안 제시

- 협력 방식: 공동 창작자 모델

**3단계: 시각화 및 프로토타이핑**

- 인간: 최종 선택, 세부 조정, 의사결정

- AI: 이미지 생성, 렌더링, 다양한 스타일 제시

- 협력 방식: 공동 창작자 모델

**4단계: 평가 및 정제**

- 인간: 창의성, 실용성, 미학적 판단

- AI: 요구사항 충족 여부, 질량 평가 지원

- 협력 방식: 제안자 + 보조자 모델

#### 3.2.2 실제 협업 사례 및 성과

**① Midjourney를 활용한 디자인 협업**

**참여자:** 전문 디자이너 및 신진 디자이너

**협업 구조:**

- 인간: 창의적 비전 제시, 스타일 정의, 최종 선택

- Midjourney: 다양한 시각화 옵션 생성, 반복 개선

**성과 지표:**

- **창의성 향상**: 전문 디자이너는 최종 산출물 품질 및 정제도에서 39% 향상 (신진 디자이너는 아이디어 생성에서 53% 향상)

- **효율성**: 개념 개발 시간 현저히 단축

- **접근성**: 신진 디자이너의 진입 장벽 낮춤

- **새로운 가능성**: 기존 디자인 소프트웨어로 불가능한 독창적 결과물 생성

**선호도 측면:**

- 정보 탐색 및 학습: 디자인 트렌드 파악에 매우 유용

- 창의적 표현: 추상적 아이디어의 시각화 실현

- 효율성: 초기 컨셉 개발 속도 증가

- 오락성: 창의적 과정 자체의 즐거움

- 사회적 연결: 창의 커뮤니티 내 상호작용

**② ChatGPT를 활용한 데이터 기반 디자인**

**협업 프로세스:**

1. 기회 발견 단계: AI와 함께 시장 기회 분석

2. 아이디어 생성: AI의 DALL-E 플러그인으로 초기 아이디어 시각화

3. 요구목록 작성: AI와 협력하여 디자인 요구사항 정의

4. 개념 디자인: 100개 시안 중 48개가 요구목록 충족 (48% 적중률)

5. 프로토타이핑: 총 2일 내에 완료

**핵심 발견:**

- AI와의 협업에서 **전략 수립 능력**과 **디자인 평가 능력**이 중요

- 디자이너의 직관과 감성이 AI의 기술적 역량과 결합할 때 가장 효과적

**③ 협업적 아이디어 생성 연구(HAI Co-ideation Framework)**

**연구 설계:**

- ChatGPT를 "Co-Ideator"로 구성

- 인간 디자이너와의 상호작용을 통해 디자인 문제 탐색

**주요 역할:**

- **적응형 디자인 파트너**: 디자이너의 사고 과정을 반영하고 창의적 아이디어 자극

- **시각화 지원**: 개념을 구체적 결과물로 실현

- **신뢰할 수 있는 협력자**: 오류 가능성 인식하면서도 신뢰 구축

**결과:**

- 참여 디자이너들의 높은 만족도

- AI의 다중 모달 능력(텍스트+이미지)이 창의 과정 강화

- 협력적 신뢰 형성의 중요성 확인

#### 3.2.3 창의성 평가 지표

디자인 협업에서 창의성은 다음 차원으로 측정된다:

| 차원 | 정의 | 측정 방식 |

|------|------|---------|

| **신기성(Novelty)** | 아이디어가 얼마나 새로운가 | 아이디어 빈도, 독창성 점수 |

| **다양성(Variety)** | 다양한 유형의 아이디어 생성 | 카테고리 수, 개념적 거리 |

| **품질(Quality)** | 아이디어의 실현 가능성 및 유용성 | 전문가 평가, 실행 가능성 |

| **정교도(Refinement)** | 최종 산출물의 완성도 | 디자인 마무리도, 세부사항 |

| **작업성(Workability)** | 아이디어의 실현 가능성 | 실행 가능한 설계 비율 |

**주목할 사항:**

- 그룹 협업 + AI: 신기성 높음 (평균 5.7/10), 작업성 낮음 (평균 4.7/10)

- 개인 협업 + AI: 신기성 낮음 (평균 2.75/10), 작업성 높음 (평균 7.5/10)

- 협업 모드에 따라 AI의 기여 양식이 달라짐

### 3.3 저널리즘 분야

#### 3.3.1 협업 모델의 유형

저널리즘에서 AI-인간 협업은 주로 **데이터 분석, 초안 작성, 편집, 배포** 단계에서 이루어진다.

**① 자동 뉴스 생성(Automated News Generation)**

**흐름:**

- 데이터 수집 → AI 분석 → 초안 생성 → 기자 검토·보완 → 편집 → 배포

**적용 사례:**

- 결산 보도: 수천 개 회사의 분기별 실적 자동 처리

- 스포츠 보도: 마이너리그 경기 기록 자동 생성

- 지역 뉴스: 선거 결과, 지역 통계 자동 작성

- 재무 뉴스: 주식 시장 동향 및 기업 공시 자동 분석

**역할 분담:**

- AI: 구조화된 데이터 처리, 기본 문장 구성, 빠른 처리

- 기자: 사실 검증, 맥락 추가, 심도 있는 분석, 배경 설명

**② 데이터 분석 및 인사이트 추출(Data Analysis & Insight Generation)**

AI가 대규모 데이터셋을 분석하여 숨은 패턴, 연관성, 이야기를 발굴하고, 기자가 이를 바탕으로 조사 보도를 진행한다.

**장점:**

- 인간이 놓치기 쉬운 패턴 발견

- 조사 보도에 필요한 시간 대폭 단축

- 더 많은 스토리 발굴 가능

**③ 팩트 체크 및 오류 감지(Fact-Checking & Error Detection)**

AI가 기사의 팩트 검증, 이미지 위변조 감지, 딥페이크 탐지 등을 지원한다.

**구체적 기능:**

- 다양한 출처 간 정보 교차 검증

- 불일치 사항 자동 감지

- 소셜 미디어 게시물의 출처 추적

- 이미지 진위 여부 판정

- 딥페이크 탐지

#### 3.3.2 실제 협업 사례 및 성과

**① 연합뉴스(Associated Press)**

**도입 시스템:** Automated News Generation

**적용 분야:**

- 분기별 실적 보도

- 마이너리그 야구 경기 기록 (연 10,000건)

- 지역 선거 결과

- 시장 동향 보도

**성과:**

- **산출량**: 분기별 실적 보도 **10배 증가**

- **오류 감소**: AI 팩트 체크 사용 시 **23% 오류 감소**

- **기자 역할 변화**: 기사 작성에서 조사 보도, 심층 분석으로 역할 전환

- **범위 확대**: 이전에 커버 불가능한 지역 뉴스도 생산 가능

**기자 증언:**

> "AI 도구는 분기별 실적 스토리 산출을 10배로 늘렸으면서도 오류를 줄였다. 이를 통해 기자들이 엔터프라이즈 업무에 집중할 수 있게 했다." - Lisa Gibbs, Director of News Partnerships, AP

**② 로이터(Reuters)**

**도입 시스템:** 자동화된 재무 보도

**특징:**

- AI가 재무 데이터 기반 초안 생성

- 기자가 신속하게 검토·보완·발행

**성과:**

- **커버리지**: 실적 보도 **400% 증가**

- **속도**: 데이터 공개 후 평균 **8분 내 기사 발행**

- **역할 전환**: 기자가 분석 및 독점 보도로 집중

**③ 워싱턴 포스트(Washington Post)**

**도입 시스템:**

- Heliograf: 구조화된 데이터 기반 자동 생성

- AI 작문 보조 도구: 인터뷰 노트 → 초안 변환

**적용 분야:**

- 고등학교 스포츠 기록

- 지역 뉴스

- 선거 결과

**성과:**

- **산출량**: 연 **850+ 자동화 기사** 발행

- **범위**: 이전에 커버 불가능한 지역까지 확대

- **시간 단축**: 보도 ~ 발행 단계 **30% 시간 단축**

#### 3.3.3 저널리즘의 협업 원칙

**뉴욕 타임스(New York Times)의 AI 사용 원칙:**

1. **미션 우선**: AI는 뉴스룸의 미션 달성에만 사용

2. **인간 감독 필수**: 모든 AI 적용에는 인간의 지도와 편집 검토가 필수

3. **투명성**: 독자가 AI의 역할을 알 수 있도록 명시

**BBC의 AI 활용:**

- AI 생성 날씨 예보: 정확성과 명확성 양립

- 편집 기준 유지: AI 자동화도 인간 기준 준수

#### 3.3.4 저널리즘에서의 성과 지표

| 지표 | 측정값 | 사례 |

|------|--------|------|

| **시간 절감** | 4-6시간/주 | 기자 평균 절감값 |

| **오류 감소** | 23% | AI 팩트 체크 적용 시 |

| **범위 확대** | 200% | 지역화 기사 평균 증가 |

| **생산성 향상** | 400% | 개별 사례(로이터 실적 보도) |

| **속도** | 8분 | 데이터 공개 후 발행 시간 |

| **자원 배치** | 68% | 조사/심층 보도로 전환한 기자 비율 |

---

## 4. 협업 모델의 성과 분석

### 4.1 창의성에 미치는 영향

#### 4.1.1 긍정적 영향

**AI의 고착 편향(Fixation Bias)과 인간의 자유도:**

AI는 훈련 데이터의 패턴을 따르므로 관례적 범주 내에서 높은 생산성을 보이는 반면, 인간은 개념적 확장(conceptual expansion)을 통해 더욱 창의적인 솔루션을 찾을 수 있다. 따라서 **AI의 광범위한 옵션 생성과 인간의 비판적 평가**의 결합이 가장 효과적이다.

**구체적 성과:**

1. **아이디어 생성 양과 다양성**

- 개별 브레인스토밍 대비 AI 협력 시 아이디어 **25-30% 증가**

- 주제 영역의 다양성 향상

- 새로운 각도의 아이디어 발굴

2. **창의성 차원별 효과**

- **신기성**: 그룹 협업 + AI에서 5.7/10 (개인 2.75/10 대비 **107% 향상**)

- **품질**: AI의 제안을 기초로 인간의 정제 과정을 거칠 때 최고

- **실현성**: AI가 기존 해결책 기반 아이디어를 제시하므로 높음

3. **경험적 충족감**

- 창의적 자기 효능감(creative self-efficacy) **향상**

- 추상적 아이디어의 시각화 경험으로 인한 만족도

- 창의적 과정 자체의 즐거움

#### 4.1.2 부정적 영향 및 한계

**AI의 창의성 결손(Creativity Deficit):**

1. **고착(Fixation) 문제**

- AI가 훈련 데이터 내 반복적 패턴에 고착

- 예상 가능하고 공식적인 아이디어 생성

- 진정한 독창성의 부족

2. **평가 능력의 한계**

- AI는 다량의 아이디어는 생성하지만, 그 독창성을 판단하지 못함

- 인간이 아이디어를 검증하지 않으면 중복되거나 미흡한 결과물 생성 가능

- 고착된 아이디어와 혁신적 아이디어의 구분 불가

3. **역할 할당의 영향**

- 인간이 **편집자(Editor)** 역할만 수행할 경우 창의성 **저하**

- 공동 창작자 역할 부여 시에만 창의성 **회복** 및 향상

- 역할이 창의적 자기 효능감과 내재적 동기에 직접 영향

**연구 근거:**

"창의적 자기 효능감이 중요" 연구에서:

- 편집자 모델: 창의성 결손 발생

- 공동 창작자 모델: 결손 해소 및 창의성 향상

- 차이의 설명 변수: **창의적 자기 효능감(creative self-efficacy)**

### 4.2 생산성 및 효율성에 미친 영향

#### 4.2.1 시간 및 노력 절감

**교육 분야:**

- 교사 채점 시간: **80% 감소**

- 수업 준비 시간: 상당한 감소

- 개인화된 피드백 생성: **자동화로 규모화**

**저널리즘:**

- 기자 일상 업무: 주당 **4-6시간 절감**

- 뉴스 발행 시간: **75-85% 단축** (사건 감지 → 발행)

- 특정 분야: 8분 내 발행 (로이터 재무 보도)

**디자인:**

- 개념 개발 단계: **현저한 시간 단축**

- 초안 작성: 2일 내에 완료 (100개 시안 생성)

- 반복 개선: 빠른 사이클 회전

#### 4.2.2 산출량 증대

**저널리즘:**

- 결산 보도: **10배 증가** (AP 사례)

- 지역화 기사: **200% 증가** (평균)

- 실적 보도: **400% 증가** (로이터 사례)

**교육:**

- 개인화된 과제: **자동 생성 규모화**

- 학습 자료: **대량 생산 가능**

**디자인:**

- 초안 생성: 하루에 **수십~수백 개** (기존 방식과 비교 불가)

#### 4.2.3 비용 절감

**McKinsey 추정:**

- 생성형 AI는 연간 **0.1~0.6%의 노동 생산성 증가** 초래 (2040년까지)

- 고객 서비스: 함수 비용의 **30-45% 절감 잠재력**

- 지식 업무(결정, 협업): **가장 큰 자동화 잠재력**

**실제 절감:**

- AI 작성 도구 사용 조직: 내부 지식 검색 시간 **대폭 단축**

- 운영 효율성 향상으로 인한 간접 비용 절감

### 4.3 학습 성과에 미친 영향

#### 4.3.1 학업 성적 향상

**통계적 근거:**

| 중재 유형 | 학습 이득 | 표본 크기 |

|----------|---------|---------|

| 지능형 튜터링 시스템 | +15-35% | 수천명 |

| AI 피드백 시스템 | +25-30% | 수백명 |

| 적응형 AI 훈련 | +35% (지식 보유) | 200명 |

| 통합 협업 모델 | +20-35% | 500명+ |

**구체적 사례:**

1. **Yixue 플랫폼**

- 사용자의 학습 이득: 5.86점 (비사용 1.04점 대비 **4.62배**)

- 세분화된 지식 콘텐츠가 주 원인

2. **하이브리드 STEM 교사 교육**

- CSPL/iHMCL 그룹: STEM 교수 지식 우수

- 인지 부하 관리 능력 향상

- 전체 학습자의 기본 심리 요구(자율성, 유능감, 관계성) 충족

3. **IT 전문가 적응형 훈련**

- 지식 보유율: **35% 증가**

- 참여도: **40% 향상**

- 훈련 시간: **22% 단축**

#### 4.3.2 참여도 및 동기 향상

1. **학생 참여도**: 20-35% 증가 (AI 지원 활동)

2. **완료율**: 높아짐 (게임화, 챗봇 인터페이스 포함 시)

3. **만족도**: 인간과 AI 피드백의 혼합 모델에서 최고

#### 4.3.3 고차 사고 능력 발달

AI와 협업할 때 인간이 더욱 높은 수준의 인지 작업으로 전환:

- **비판적 사고**: AI 제안 평가 시 발달

- **문제 해결**: 새로운 맥락에서의 적용 연습

- **창의적 사고**: 아이디어 발산 단계에서 증진

- **메타인지**: AI와의 상호작용을 통한 자기 반성

### 4.4 비교 분석: 분야별 성과 차이

#### 4.4.1 교육 vs. 디자인 vs. 저널리즘

| 차원 | 교육 | 디자인 | 저널리즘 |

|-----|------|--------|---------|

| **주요 협업 모델** | 보조자 + 공동 창작자 | 공동 창작자 + 제안자 | 보조자 + 제안자 |

| **시간 절감** | 80% (채점) | 현저 (초안) | 75-85% (발행) |

| **산출량 증가** | 규모화 | 수십배 | 10-400배 (분야별) |

| **창의성 향상** | 중간-높음* | 높음** | 낮음*** |

| **오류율** | 낮음(적절한 모델링) | 인간 평가 필수 | 23% 감소(팩트체크) |

| **인간 개입 수준** | 높음(최종 검증) | 중간-높음(평가/정제) | 높음(사실확인) |

**주석:**

- *높음: 공동 창작자 모델, 낮음: 편집자 역할만 할 경우

- **높음: 신기성(novelty)은 5.7/10으로 향상, 다만 실현성 고려 필요

- ***낮음: 저널리즘은 AI가 보조적 역할만 수행하므로 창의성보다 효율성에 집중

#### 4.4.2 분야별 특성

**교육:**

- 개인화(personalization)에서 최고 효과

- 규모화 가능성이 높음 (수천~수백만 학생)

- 인간(교사)의 역할 변화: 지식 전달 → 멘토링, 동기부여

**디자인:**

- 아이디어 생성 단계에서 최고 가치

- 신진 창작자에게 진입 장벽 완화

- 전문가: 품질/정제도 향상에 집중

**저널리즘:**

- 일상적, 반복적 뉴스(금융, 스포츠, 선거)에서 최고 효과

- 조사 보도, 심층 보도는 여전히 인간 중심

- 팩트 체크에서 보조 역할 강화

---

## 5. 협업 모델의 한계 및 도전 과제

### 5.1 창의성과 진정성의 문제

#### 5.1.1 AI의 고착 편향(Fixation Bias)

**문제:**

- AI는 훈련 데이터의 패턴에 기초하므로, 새로운 아이디어의 생성 능력이 제한됨

- 관례적이고 예상 가능한 결과가 대부분

- 진정한 혁신(disruption)을 기대하기 어려움

**구체적 근거:**

ChatGPT의 창의성 분석:

- 생산성(productivity): 인간을 초과

- 고착 편향: 인간과 유사한 수준

- 독창성 평가 능력: **인간에 비해 현저히 낮음**

**함의:** AI와의 협업이 새로운 아이디어는 많이 생성하지만, 그 중 진정한 독창성을 갖춘 것의 비율은 인간의 비판적 평가에 의존한다.

#### 5.1.2 인간의 창의성 감퇴(Creativity Atrophy)

**위험:**

- AI의 도움이 과도해질 경우, 인간의 창의적 사고 능력이 저하될 수 있음

- 인간이 AI 출력에 과도하게 의존할 경우, 독립적 사고 능력 약화

**근거:**

- "일단 AI에 의존하게 되면, AI 없는 상황으로 돌아가기 어렵다"는 저널리스트 증언

- 과도한 자동화는 인간의 비판적 사고 능력 저하 가능성

**완화 방안:**

- AI를 "보완 도구"로서 명확히 정의

- 인간의 역할을 공동 창작자로 설정 (편집자가 아닌)

- 정기적인 AI 없는 과제 수행으로 독립 능력 유지

### 5.2 윤리 및 책임 문제

#### 5.2.1 저작권 및 지적재산권

**문제:**

- AI 훈련에 사용된 원본 저작물의 저작권자 동의 부재

- "이 작품의 저작자는 누구인가?" 질문에 대한 법적 답변 부재

- AI 기여도에 따른 저작권 배분 기준 불명확

**사례:**

- 다수의 고소(미국, 유럽): 저작물 무단 수집 및 학습 관행

- 규제 동향: EU GDPR, California CCPA 등 개인정보 보호 강화

**현 상황:**

- 국제적 합의 부재

- 기업과 창작자 간 법적 분쟁 증가

- 해결책: 투명한 데이터 거버넌스, 저작권자 동의 시스템, 이용료 배분 모델

#### 5.2.2 편향(Bias)과 차별

**문제:**

- AI는 훈련 데이터의 편향을 학습하고 재현

- 성별, 인종, 문화적 편향 가능성

- 교육, 저널리즘에서 특히 심각한 윤리 문제

**교육 분야:**

- AI 평가 시스템의 편향성 검증 필수

- 특정 집단에 불리한 결과 가능성

- 데이터 다양성 부족 시 문제 심화

**저널리즘:**

- AI가 생성한 기사의 관점 편향 가능성

- 소수 집단 보도에서의 스테레오타입 강화 위험

- 알고리즘 기반 뉴스 선택의 확증 편향(confirmation bias)

**대응:**

- 다양한 데이터셋으로 훈련

- 정기적인 편향 감시(bias audit)

- 인간의 최종 검증 필수

#### 5.2.3 투명성 부족(Opacity/Black Box Problem)

**문제:**

- 특히 심층 학습 모델은 어떤 방식으로 결정을 내리는지 설명하기 어려움

- 사용자가 AI의 판단 근거를 이해 불가

- 교육, 저널리즘에서 신뢰 저하

**건강 분야 사례:**

- 의사가 AI의 진단을 받아들이려면 그 근거를 알아야 함

- XAI(Explainable AI) 연구 강화 필요

**대응:**

- 설명 가능한 AI(XAI) 개발

- 프롬프트 내 명확한 지시사항 제공

- AI 기여도 명시

### 5.3 인간 자율성과 역량 약화

#### 5.3.1 역할 할당의 중요성

**발견:**

- 인간이 **편집자** 역할을 맡을 경우: 창의성 저하

- 인간이 **공동 창작자** 역할을 맡을 경우: 창의성 향상

**원인:**

- 역할 기대(role expectation)가 행동과 성과를 직접 결정

- 편집자 역할 = 수동적, 반응적 → 내재적 동기 약화

- 공동 창작자 역할 = 능동적, 주도적 → 내재적 동기 증대

**함의:**

- AI 도입 시 인간의 역할을 명확히 정의해야 함

- 인간을 주도자로 배치하는 것이 중요

#### 5.3.2 인지 부하(Cognitive Load) 관리

**문제:**

- AI의 과도한 옵션 제시 시 선택 마비(choice paralysis)

- 과도한 정보로 인한 인지 부하 증가

- 과도한 자동화로 인한 "자동화 나태"(automation complacency)

**구체 사례:**

- 의료 AI: 과도한 알림으로 인한 경각심 저하

- 교육: 너무 많은 선택지로 인한 학습 방해

**대응:**

- 적절한 정보 규모 설계

- 인간의 선택권과 통제권 명시

- 적응형 인터페이스로 개인 맞춤화

### 5.4 분야별 특정 문제

#### 5.4.1 저널리즘

**① 신뢰성 문제**

- 독자들이 AI 생성 기사를 더 부정확하다고 인지 (실제 정확성과 무관)

- 언론 신뢰도 저하 가능성

- 투명성 필수 (AI 사용 명시)

**② 기자 직업 위협**

- 자동화 가능한 기사(결산, 스포츠, 날씨) 감소

- 다만, 조사 보도, 심층 분석 등 고가치 업무는 인간 의존성 높아짐

- 전체적 고용 영향은 불명확

**③ 편집 기준 유지**

- AI가 뉴스룸의 윤리적 기준을 충분히 반영할 수 있는가?

- 인간의 편집 기준이 강화되어야 함

#### 5.4.2 교육

**① 평가 신뢰성**

- AI 기반 평가의 정확성 확보

- 학생 특성(장애, 언어 능력)에 따른 편향 검증

**② 학습 진정성**

- AI가 학생 과제를 대신 수행할 가능성

- 학습 결과의 적실성 검증 필수

**③ 교사 역할 변화**

- 교사가 "감독자"에서 "멘토"로 변화

- 재교육 및 역량 개발 필요

#### 5.4.3 디자인

**① 진정한 협력인가?**

- 일부는 AI를 단순한 "도구" 보다는 "협력자"로 인식하지만, 실제 협력 정도는 개인차 큼

- 설계자의 의도가 최종 산출물에 얼마나 반영되는가?

**② 저작권 문제**

- Midjourney, DALL-E 학습에 포함된 디자이너의 미지급 저작료

- 원 저작물 보호 메커니즘 부재

**③ 창의성의 탈중앙화**

- AI 접근성이 높아지면서 전문 디자이너의 차별성 감소 우려

- 다만, 초기 콘셉트 개발에서는 경험이 여전히 중요

---

## 6. 협업 모델 발전 방향 및 권고

### 6.1 협업 설계의 원칙

#### 6.1.1 역할의 명확성(Role Clarity)

**권고:**

1. 인간과 AI의 역할을 명시적으로 정의

2. 인간을 **공동 창작자** 또는 **최종 의사결정자**로 배치

3. 편집자 역할만 부여하지 않기

4. 정기적 역할 재검토

**효과:**

- 창의적 자기 효능감 유지

- 내재적 동기 보존

- 더 나은 협업 성과

#### 6.1.2 투명성과 설명 가능성(Transparency & Explainability)

**교육 분야:**

- AI 기반 피드백이 왜 그런 판단을 했는지 설명

- 설명 가능한 AI(XAI) 통합

- 교사가 AI 판단에 의문을 제기할 수 있는 구조

**저널리즘 분야:**

- AI 사용 명시 (독자 신뢰 유지)

- AI-생성 기사 표시

- 팩트 체크 과정 투명화

**디자인 분야:**

- AI의 아이디어 출처 명시

- 인간의 기여도 명확화

#### 6.1.3 인간 감독 유지(Human Oversight)

**원칙:**

1. 모든 AI 산출물에 최종 인간 검증 필수

2. 특히 고위험 결정(교육 평가, 의료, 법률)은 더욱 엄격한 검증

3. AI가 제안하면 인간이 최종 결정

**구현:**

- 다층 검증 프로세스 구축

- 인간의 명확한 책임 구조

- 이상 탐지(anomaly detection) 시스템

### 6.2 기술적 발전 방향

#### 6.2.1 공생적 AI(Symbiotic AI)

**개념:**

- AI와 인간이 각각의 강점을 보완하며 협력

- "인간의 직관 + AI의 계산 능력"

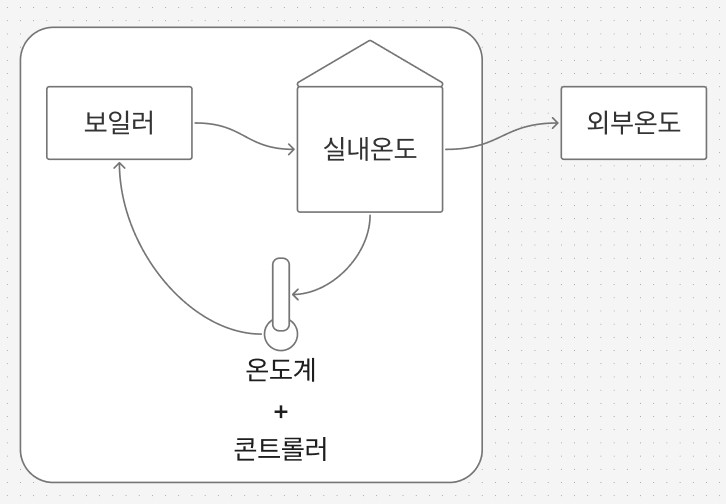

**기술적 구현:**

1. **전이 학습(Transfer Learning)**

- 한 분야의 전문성을 다른 분야에 전수

- 인간 전문가의 지식이 AI를 통해 전달, 재증식

2. **능동 학습(Active Learning)**

- AI가 불확실한 상황 인식 → 인간에게 도움 요청

- 인간 피드백을 통한 지속적 개선

3. **적응형 인터페이스**

- 사용자의 전문 수준에 따른 맞춤형 인터페이스

- 학습 곡선 최소화

#### 6.2.2 평가 자동화의 고도화

**현황:**

- LLM 기반 창의성 평가 모델 개발 중

- 인간 전문가 평가와 AI 평가의 정렬(alignment) 향상 중

**권고:**

- 평가 기준의 명확한 정의

- 기계 학습 기반 평가와 인간 평가의 혼합 모델

- 평가 시스템의 정기적 재검증

### 6.3 조직 및 정책 차원의 권고

#### 6.3.1 UNESCO 및 OECD의 정책 방향

**UNESCO AI 정책 권고(2021, 2023):**

1. **교육 내 AI의 윤리적 활용**

- 인간 중심의 humanistic 접근

- 데이터 거버넌스 강화

- 포용성과 형평성 확보

2. **AI 리터러시 교육**

- 학생과 교사 모두에게 필수

- AI 원리, 한계, 윤리 이해

3. **규제 체계**

- 국가 수준의 정책 개발

- 데이터 보호 규정 강화

- 이해관계자 간 공개 토론 촉진

4. **전략적 영역**

- AI를 통한 교육 관리 효율화

- 학습자 중심의 AI 활용

- 교육 평가 혁신

- 학습 데이터의 투명한 감시

**OECD 권고:**

- 공정성(fairness), 책임성(accountability), 투명성(transparency) 강조

- AI 기술 채택이 양극화를 심화하지 않도록 주의

- 노동 시장 변화에 대한 대비

#### 6.3.2 조직 차원의 구현

**① 거버넌스 체계 구축**

- AI 윤리 위원회 설립

- 정기적 감시 및 감사

- 투명한 의사결정 구조

**② 인력 개발**

- AI 협업 능력 교육

- 비판적 평가 능력 강화

- 윤리 교육

**③ 표준화**

- 산업별 최적 관행(best practice) 개발

- 평가 기준 표준화

- 공개 데이터셋 구축

#### 6.3.3 분야별 정책 제안

**교육:**

- AI 기반 개인화 학습의 규모화

- 교사 역할 재정의 및 재교육

- 평가 혁신 (AI 보조, 인간 최종)

**저널리즘:**

- AI 활용 투명성 규범화

- 팩트 체크 도구의 신뢰성 검증

- 고용 안정성 정책 (자동화 지원, 재교육)

**디자인:**

- 저작권 보호 강화

- AI 생성 콘텐츠 명시 의무화

- 신진 디자이너 지원 정책

### 6.4 향후 연구 방향

#### 6.4.1 학술 연구

**필요한 연구 주제:**

1. **장기 효과 분석(Longitudinal Studies)**

- 1년 이상의 추적 연구로 지속적 영향 측정

- 중단 후 인간 역량 회복 양상 분석

2. **다양한 맥락에서의 효과**

- 다양한 문화, 교육 수준, 연령대에서의 효과

- 사회경제적 배경에 따른 차이 분석

3. **창의성 평가 방법론**

- 더욱 정교한 창의성 측정 틀 개발

- 다차원적 평가 기준의 표준화

4. **윤리 및 사회 영향**

- AI 협업이 불평등을 심화하는가?

- 전문직(기자, 교사, 디자이너)의 역할 변화 추이

#### 6.4.2 산업 연구

1. **최적 협업 구조 발굴**

- 각 분야별, 각 조직별 맞춤형 모델 개발

- ROI 측정 및 비용-편익 분석

2. **인터페이스 개선**

- 사용자 경험(UX) 최적화

- 인지 부하 최소화

3. **통합 프로세스 모델**

- 기존 업무 프로세스와의 매끄러운 통합

- 변화 관리 전략

---

## 7. 결론 및 종합 고찰

### 7.1 핵심 발견 정리

#### 7.1.1 협업 모델의 다양성과 효과성

생성형 AI와 인간의 협업은 단일한 형태가 아니며, **보조자(Assistant), 공동 창작자(Co-creator), 제안자(Suggester)** 등 다양한 모델로 나타난다. 각 모델은 문맥과 목표에 따라 다양한 효과를 보인다:

- **보조자 모델**: 일상적, 반복적 업무의 자동화에 최적. 시간과 비용 절감이 주된 효과.

- **공동 창작자 모델**: 창의성, 혁신성 추구 시 가장 효과적. 인간의 창의적 자기 효능감 유지 및 증진.

- **제안자 모델**: 선택의 폭을 넓혀 창의적 시각 확대. 인간의 비판적 판단을 전제.

#### 7.1.2 분야별 차이와 공통점

**공통점:**

- 모든 분야에서 **시간과 생산성 향상**

- 인간의 역할이 **반복적 업무에서 고차 사고로 전환**

- **인간 감독(human oversight)이 필수 불가결**

- 역할 할당의 방식이 **성과를 크게 좌우**

**차이점:**

- **교육**: 개인화와 규모화에서 최고 효율. 장기 학습 효과 검증 필요.

- **디자인**: 아이디어 생성과 시각화에서 최고 가치. 신진 창작자의 진입 장벽 완화.

- **저널리즘**: 반복적 뉴스(금융, 스포츠)의 자동화에 최고 효율. 조사 보도는 여전히 인간 주도.

#### 7.1.3 성과 지표의 명확성

**정량적 성과:**

- 시간 절감: 22~80% (분야와 업무에 따라)

- 산출량 증가: 10~400% (자동화 가능 분야)

- 학습 성과: 15~35% 향상

- 오류 감소: 23% (팩트 체크 적용)

**정성적 성과:**

- 창의성: 조건부 향상 (공동 창작자 역할 시)

- 만족도: 높음 (역할이 명확하고 인간이 주도권 보유 시)

- 신뢰도: 투명성과 감독 수준에 따라 좌우

#### 7.1.4 한계와 위험성

**기술적 한계:**

- AI의 고착 편향(fixation bias): 혁신적 아이디어 생성 제한

- 평가 능력: 생성은 많지만 평가 능력은 낮음

- 투명성: 특히 심층 학습 모델의 의사결정 근거 설명 어려움

**윤리적 문제:**

- 저작권: 훈련 데이터 무단 사용 문제 미해결

- 편향: 학습 데이터의 편향이 재현될 위험

- 자율성: 과도한 자동화로 인한 인간 역량 약화 가능성

**사회적 영향:**

- 고용: 특정 직종(자동화 가능한 작업)에 부정적 영향 가능

- 불평등: 고급 AI 도구 접근성의 불균등 분포

- 신뢰: 언론, 교육 등 신뢰 기반 분야에서 신뢰도 저하 우려

### 7.2 이론적 함의

#### 7.2.1 역할 할당의 중요성

최근 연구는 **역할의 할당이 협업 성과를 결정하는 핵심 변수**임을 보여준다:

- 인간이 **편집자** 역할 → 창의적 자기 효능감 ↓, 내재적 동기 ↓, 창의성 결손

- 인간이 **공동 창작자** 역할 → 창의적 자기 효능감 ↑, 내재적 동기 ↑, 창의성 회복 및 향상

이는 인간-AI 협업의 성공이 **기술 자체가 아니라 협업 구조 설계**에 달려 있음을 시사한다.

#### 7.2.2 공생적 협업의 필요성

"Symbiotic AI"의 개념은 AI와 인간이 각각의 강점을 보완하는 체계를 제시한다:

| 인간의 강점 | AI의 강점 |

|-----------|---------|

| 직관 | 데이터 처리 |

| 창의성 | 규모화 |

| 윤리적 판단 | 일관성 |

| 맥락 이해 | 패턴 인식 |

| 목적 설정 | 최적화 |

최적의 협업은 이들 강점을 **의도적으로 결합**하는 데 있다.

#### 7.2.3 지식 노동의 변화

McKinsey 분석에 따르면, 생성형 AI는 기존 자동화가 어려웠던 **지식 노동(knowledge work)**, 특히 **의사결정과 협력 활동**에 가장 큰 영향을 미친다. 이는:

1. 노동의 특성 변화: 자동화 가능한 작업 감소 → 창의성, 비판적 사고, 대인관계 능력의 중요성 ↑

2. 직업 재구성: 전통적 직책 축소 → 새로운 역할 창출

3. 교육의 방향성: 기술 교육과 인간 중심 역량(creativity, ethics, emotional intelligence) 동시 강화 필요

### 7.3 실천적 권고

#### 7.3.1 조직 차원

**즉시 실행 과제:**

1. AI 협업 정책 수립 (역할 명시, 감독 구조)

2. 이해관계자 교육 (AI의 가능성과 한계)

3. 투명성 확보 (AI 사용 공개)

**중기 과제(1-2년):**

1. 최적 협업 구조 발굴 및 표준화

2. 인간의 역할 재정의 및 역량 개발

3. 평가 및 모니터링 체계 구축

**장기 과제(2년 이상):**

1. 문화적 변화 (AI를 협력자로 인식)

2. 기술 고도화 (설명 가능한 AI, 적응형 인터페이스)

3. 지속적 학습 문화

#### 7.3.2 정책 차원

**국가 수준:**

- AI 거버넌스 법제화 (데이터 보호, 윤리 기준)

- 재교육 및 역량 개발 지원

- 공개 데이터셋 및 도구 제공

**산업 차원:**

- 자율 규범화 (self-regulation)

- 최적 관행(best practice) 공유

- 표준화 및 인증 체계

**교육 기관:**

- AI 기반 학습 인프라 구축

- AI 리터러시 교육 통합

- 교사 역량 개발

### 7.4 미해결 문제와 향후 연구

**긴급한 연구 과제:**

1. **장기 효과**: 1년 이상 추적 연구로 지속적 영향 규명

2. **공정성**: 다양한 인구집단에 따른 효과 차이 분석

3. **저작권**: 국제적 합의와 보상 체계 개발

4. **창의성 평가**: 다차원적 평가 틀의 표준화

5. **사회 영향**: 고용, 불평등, 신뢰 등 거시적 영향 분석

**이론적 과제:**

1. **공생 모델의 정교화**: 어떤 조건에서 어떤 형태의 협업이 최적인가?

2. **인간 역량의 변화**: 협업이 인간의 능력을 어떻게 변형시키는가?

3. **창의성의 본질**: AI와의 협업이 창의성의 의미를 어떻게 변화시키는가?

### 7.5 최종 결론

생성형 AI와 인간의 협업은 **교육, 디자인, 저널리즘 분야에서 이미 현실**이며, 구조적으로 설계되고 윤리적으로 감독될 때 **실질적인 가치를 창출**한다.

**핵심 메시지:**

1. **협업은 자동으로 일어나지 않는다.** 의도적 설계, 명확한 역할 할당, 지속적 감독이 필수.

2. **인간의 역할이 가장 중요하다.** 기술의 진보보다 **인간을 어떻게 배치할 것인가**가 성공을 결정.

3. **분야별, 맥락별 맞춤형 접근이 필요하다.** 일반화된 해결책은 없으며, 각 조직과 문맥에 맞는 모델 발전이 중요.

4. **윤리와 투명성이 장기 지속성을 결정한다.** 단기 효율성보다 신뢰, 공정성, 책임성의 확보가 더욱 중요.

5. **인간의 창의성과 비판적 사고는 여전히 대체 불가능하다.** AI는 인간의 능력을 **증폭(amplify)**할 수 있지만 **대체(replace)**할 수 없다.

따라서 AI와의 협업의 미래는 **기술 혁신**이 아니라 **인간 중심의 설계 철학**, **윤리적 거버넌스**, **지속적 학습과 적응**에 달려 있다.

---

## 참고 자료 범위

본 선행연구는 2018-2025년의 다음 출처를 종합했습니다:

**학술 데이터베이스:**

- Google Scholar, ACM Digital Library, IEEE Xplore, SpringerLink

- 한국학술정보(KCI), DBpia

**주요 저널 및 논문:**

- AI-EDAM (AI and Engineering Design), Nature, Frontiers in Education

- Various proceedings from HCI, educational technology, design conferences

**산업 리포트:**

- McKinsey Global Institute

- Gartner Hype Cycle for Emerging Technologies

- UNESCO Guidance on Generative AI in Education

- OECD Education Policy Reports

**주요 기관의 실제 사례:**

- Associated Press, Reuters, Washington Post, BBC, New York Times

- Educational institutions and design firms utilizing AI

**규제 및 정책:**

- EU GDPR, CCPA

- UNESCO 2021 AI Ethics Recommendation

- Various national AI governance frameworks